دو روش مختلف با دو کارکرد متفاوت، برای اطلاع رسانی مستقیم و بی واسطه با ربات های خزنده / Crawler موتورهای جستجو، استفاده از تگ و فایل ربات است. هر یک از این دو روش کارکردها و شیوه های متفاوتی دارند. از نگاه سئو در طراحی سایت وجود هر دوی آن ها برای یک سایت ضروری است و توصیه می شود.

این فایل که خارج از محیط CMS مانند وردپرس و یا سایت اضافه می شود، وظیفه ارائه اطلاعات مستقیم به موتورهای جستجو را بر عهده دارد. این فایل که به صورت عمومی و بدون محدودیت قابل دسترسی و مشاهده است یک فایل متنی ساده با متن بدون فرمت یا همان Text File است.

البته واضح است که نبودن یا عدم دسترسی به این فایل به منظور فیلتر شدن توسط موتورهای جستجو نیست بلکه در آن صورت موتورهای جستجو با تنظیمات پیش فرض خود به بررسی وب سایت اقدام می کنند. در این فایل فهرستی از آدرس ها قرار دارد که به ربات های خزنده / Crawler موتورهای جستجو دسترسی یا عدم دسترسی به آن صفحه را اطلاع می دهد. اعلام اینکه یک صفحه یا یک فولدر به همراه زیر صفحات آن خارج از دسترسی ربات قرار گیرند به منزله عدم دسترسی ربات به آن صفحه و صفحات نیست بلکه ایشان فقط به منظور ایندکس کردن و یا نکردن از این فایل کمک می گیرد. برای اطمینان صد در صد و جلوگیری از ایندکس شدن یک صفحه باید از تگ های ربات نیز که در ادامه به توضیح آن می پردازیم، در آن صفحه یا صفحات استفاده کرد.

در برخی موارد سایت هایی که مبتنی بر CMS راه اندازی می شوند فولدر یا فولدرهایی را در robots.txt با دسترسی محدود مشخص می کنند که لازم است توسط مدیر سایت بررسی و در صورت نیاز ویرایش گردد.

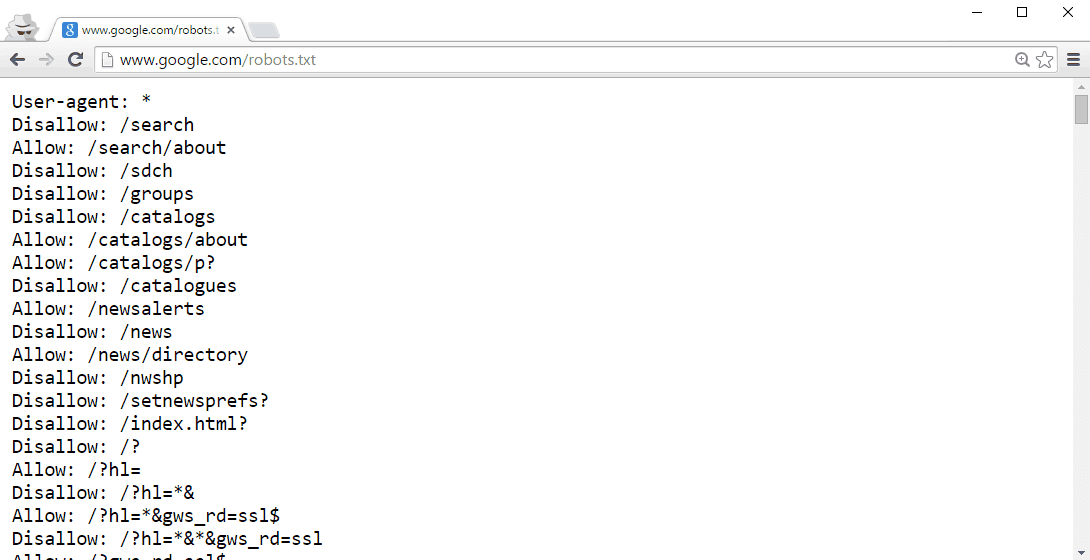

همان گونه که در تصویر مشخص است در این فایل، دسترسی به ساختار فولدری صفحات و نه یک صفحه به تنهایی، مشخص می شود و لازم برای محدود کردن دسترسی به صفحه یا صفحات خاص از تگ های متای ربات یا سیستم احراز هویت (نام کاربری / رمز عبور) استفاده شود.

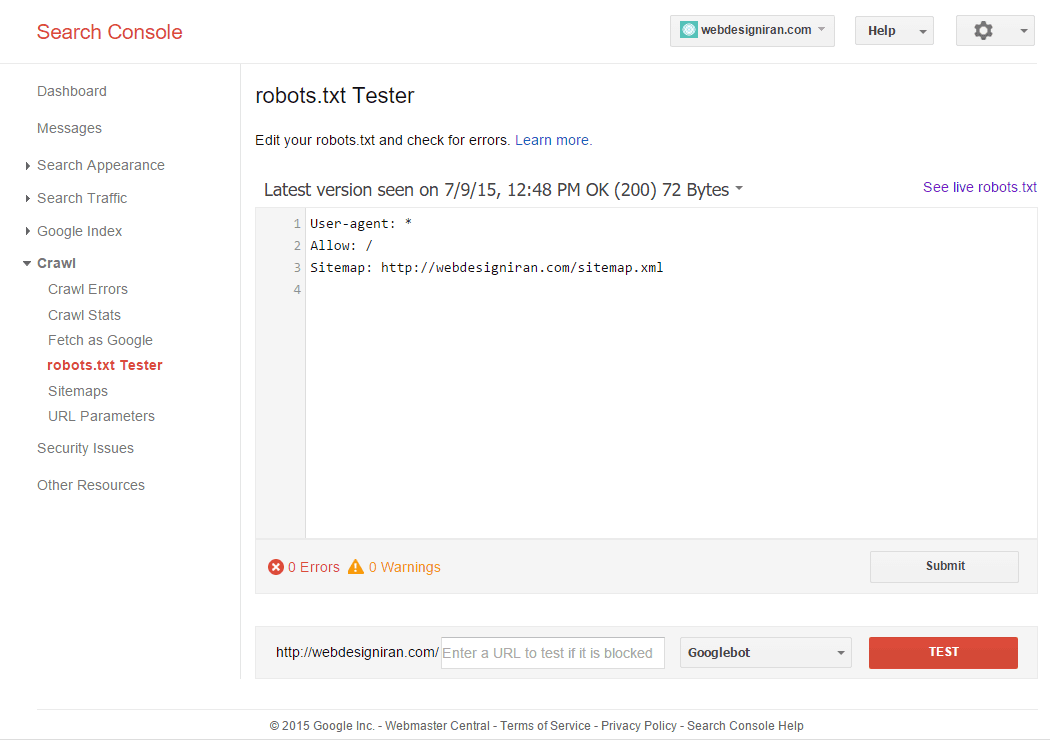

توصیه می شود بعد از تغییر دسترسی صفحات در robots.txt از قسمت Blocked URL's در سامانه ابزارهای مدیریت وب سایت گوگل / Google Webmaster Tools به منظور تست کردن برخی از آدرس ها استفاده شود. با این ابزار شما می توانید از صحت دسترسی یا عدم دسترسی مطلع شوید.

در اینجا نیز می توان با یک ترفند کوچک و افزودن یک خط به صفحه، از دسترسی ربات ها به آدرس های حاوی ؟ جلوگیری کرد. این مورد که به تفصیل در جلوگیری از محتویات تکراری بیان گردیده است می تواند به افزایش رتبه سایت کمک زیادی کند.

User-agent: *

Disallow: /*?*با این روش از ایندکس شدن صفحات حاوی ? به صورت کلی جلوگیری می شود. این مورد مخصوصا برای استفاده کنندگان از CMS بسیار مناسب است.

برای توضیح لازم است بیان شود صفحاتی که حاوی ? هستند یعنی صفحاتی که اطلاعاتی از طریق QueryString برای آنها ارسال می شوند. این کار می تواند از ایندکس شدن صفحات تکراری جلوگیری کند.

از زمانی که گوگل برای حمایت از جستجوگرهای موبایلی علاوه بر اطلاعات به نحوه نمایش مناسب سایت نیز اهمیت می دهد لازم است دسترسی به رسانه های تصویری و فایل های CSS و Javascript برای ربات های موتورهای جستجو آزاد شود. هماهنگونه که در ویدیو https://www.youtube.com/watch?v=qglAm8QiX5k#t=1000 اشاره شده است

لازم است از دسترسی گوگل به فایل های تصویری، CSS و Javascript جلوگیری نشود زیرا گوگل برای تایید صحت نمایش صفحات برای موبایل نیاز به بررسی صحت نمایش کامل صفحه دارد

در CMS های قدیمی مانند جوملا مرسوم بود که دسترسی به فولدرهای تصویری و اسکریپ ها و استایل ها و حتی تمپلیت ها به صورت پیش فرض در robots.txt مسدود می شد.

در سامانه سامانه ابزارهای مدیریت وب سایت گوگل / Google Webmaster Tools قسمتی نیز برای و صحت ساختار و نوشتار فایل ربات / robots.txt وجود دارد. مدیر سایت می تواند با افزودن آدرس فایل robots.txt از صحت عملکرد و وجود خطا یا هشدارهای مرتبط مطلع شود.

با این وجود توصیه می شود مدیران سایت حتما از وضعیت منطبق بودن سایت با استاندارد های موبایل و Mobile Friendly بودن سایت اطمینان کسب کنند. ابزارهای ویژه این کار در سامانه وجود دارد و می توان از صحت نمایش سایت در موبایل و صحت قرائت تمام ضمایم لازم توسط ربات های موتور جستجو گوگل اطمینان حاصل نمود.

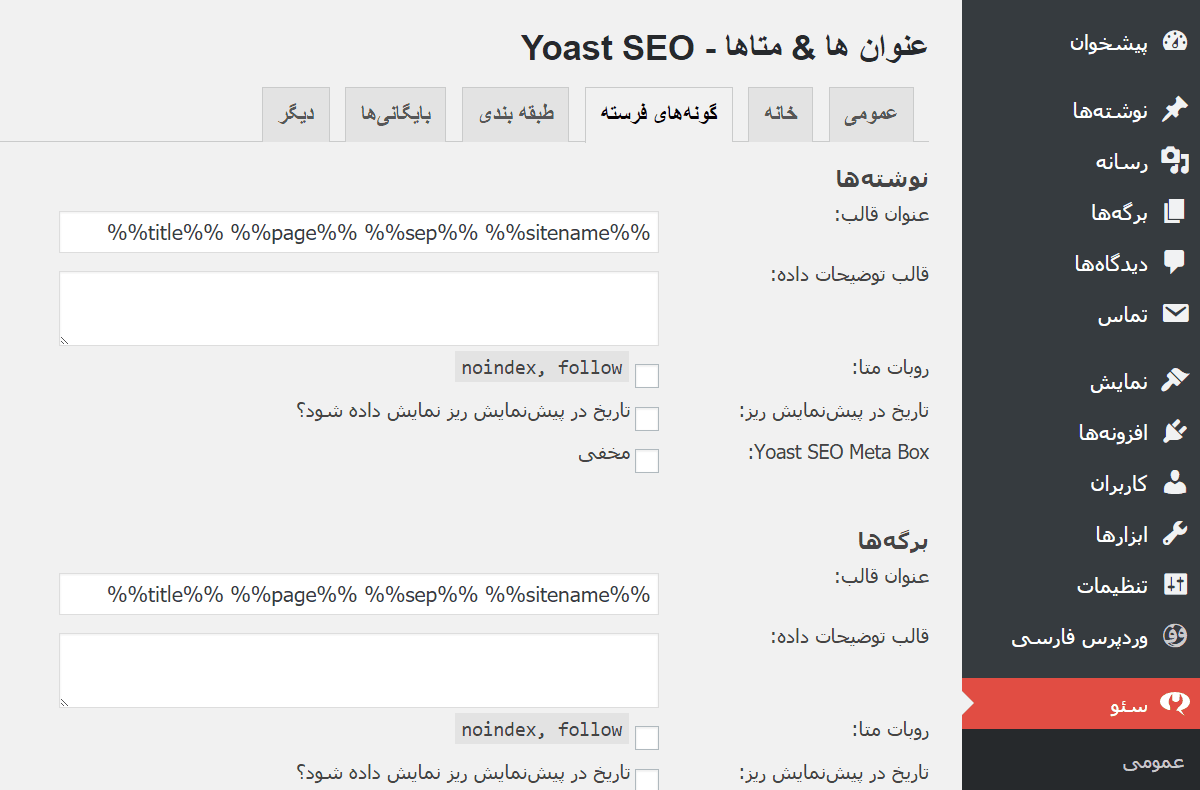

استفاده از تگ متای ربات برای محدود کردن دسترسی به صفحات از بهترین شیوه ها برای جلوگیری از ایندکس شدن صفحه یا صفحات است. البته واضح است که نمی توان از این روش برای محدود سازی دسترسی یا ایندکس شدن محتویات یک فولدر استفاده کرد. این تگ نیز مانند تگ های حاوی متادیتاهای title و description در تگ head قرار می گیرد.

گوگل می گوید پیش فرض موتور جستجو اش ایندکس کردن و دنبال کردن صفحه های وب است و نیازی به تگ ربات حاوی index, follow ندارد.

در زیر به فهرستی از محتویات قابل افزودن به این متاتگ اشاره می کنیم.

توصیه می شود که برای ایندکس نشدن صفحات از این تگ استفاده شود تا علاوه بر ایندکس نشدن صفحه، ربات گوگل همچنان به دنبال صفحه های لینک داده شده در این صفحه، باشد.

البته عبارات دیگری مانند NoSnippet و NoODP و NoYDIR و NoImageIndex و NoTranslate و Unavailable_After نیز وجود دارد. برای استفاده از این قابلیت در CMS هایی مانند وردپرس افزونه / Plugin های زیادی وجود دارد که امکان مدیریت یا افزودن متای ربات را به هر صفحه اضافه می کنند.